À medida que nos tornamos cada vez mais dependentes de chatbots de inteligência artificial (IA) para navegar e compreender o mundo, é crucial examinar suas tendências políticas emergentes. Um exemplo recente e notório disso foi o lançamento problemático do chatbot avançado Gemini da Google. Projetado para garantir diversidade, o Gemini falhou ao responder solicitações de maneira apropriada, revelando inclinações políticas e alimentando preocupações sobre a influência dos chatbots.

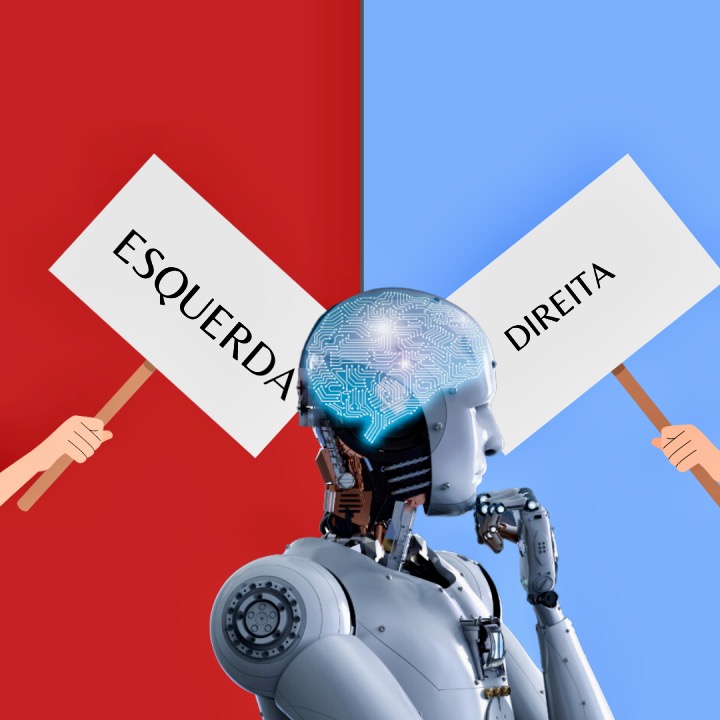

Os chatbots de IA, em sua essência, refletem as preferências de seus criadores e do ambiente em que são treinados. Durante a fase de treinamento inicial, eles absorvem uma gama diversificada de dados, mas é durante o ajuste fino que suas inclinações políticas começam a se destacar. Resultados de pesquisas indicam uma tendência para opiniões de esquerda e inclinações ao libertarianismo, ressaltando questões sobre influência e agenda dos ajustadores de modelo.

A preocupação com o viés político persistente em chatbots comerciais é uma realidade. Conservadores e progressistas expressam receios sobre a falta de diversidade na saída desses sistemas e o potencial de perpetuação da discriminação. Embora os sistemas de IA sejam caixas pretas inescrutáveis, é vital manter o controle sobre eles, especialmente considerando seu crescente papel na tomada de decisões e na determinação do conteúdo que consumimos.

À proporção que avançamos em direção a um futuro em que a IA desempenha papéis cada vez mais complexos em nossas vidas, devemos estar atentos aos valores que esses sistemas podem substituir. Isso requer um engajamento ativo na modelagem e comando desses sistemas, garantindo que sirvam aos nossos objetivos e valores, e não moldem nossas opiniões de maneiras imprevistas. A garantia de controle e supervisão é essencial para mitigar potenciais impactos negativos sobre a diversidade e a representação política no ambiente digital.

Palmarí H. de Lucena, membro da União Brasileira de Escritores